Konekcionizem je pristop k razumevanju človeškega mišljenja, ki predpostavlja, da lahko kognitivne procese razložimo preko delovanja umetnih nevronskih mrež.

Ti modeli posnemajo strukturo možganov, v katerih je znanje zapisano v medsebojnih povezavah preprostih enot, podobnih nevronom. Ključno vlogo igrajo uteži, ki določajo moč teh povezav in se spreminjajo z učenjem.

Trije razvojni valovi konekcionizma

Prvi val konekcionizma se začne leta 1943 z delom McCullocha in Pittsa, ki sta zasnovala prvi formalni model idealiziranega nevrona. Frank Rosenblatt je leta 1958 predstavil Perceptron, ki je bil sposoben razločevanja med enostavnimi liki, vendar ni znal obdelovati nelinearno ločljivih funkcij (npr. XOR). To pomanjkljivost sta izpostavila Minsky in Papert (1969), kar je povzročilo upad zanimanja za to področje v naslednjih desetletjih.

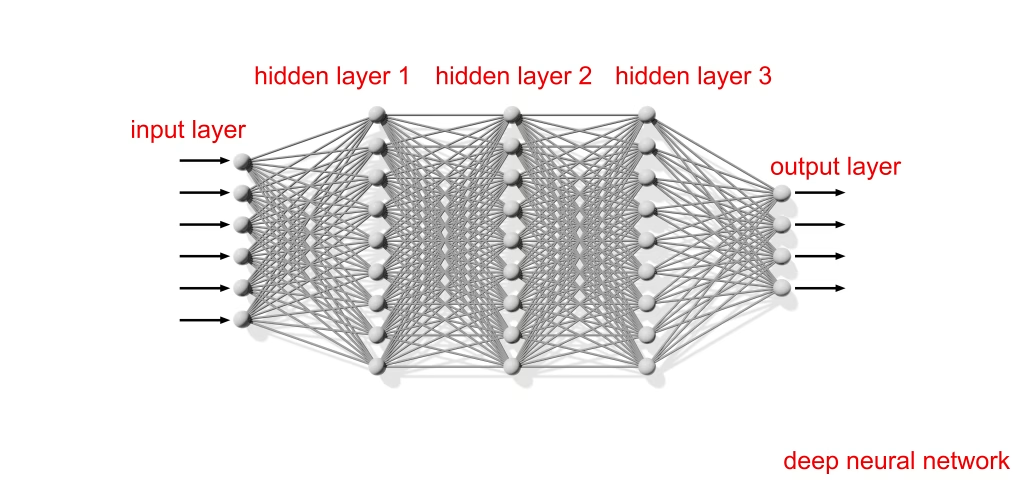

Drugi val se začne v 80. letih z razvojem večnivojskih mrež in algoritma backpropagation (povratno širjenje napake), ki je omogočil učenje v skritih slojih. Pomembno delo v tej fazi je Parallel Distributed Processing (McClelland, Rumelhart, 1987), ki uvaja koncept paralelnega procesiranja in emergentnega vedenja iz preprostih lokalnih interakcij.

Tretji val je zaznamovan z razvojem globokih nevronskih mrež (deep learning), ki so omogočile uporabo modelov pri kompleksnih nalogah, kot so prepoznavanje vzorcev, razumevanje jezika in igranje iger.

Modeli, kot je GPT, izhajajo prav iz tega razvojnega toka. Uspehi sodobnih modelov so povzročili novo rast zanimanja za konekcionistične pristope, a tudi odprli vprašanja o razumljivosti in interpretabilnosti teh sistemov.

Temeljno delovanje mrež

Konekcionistične mreže so sestavljene iz enot, ki obdelujejo informacije s pomočjo aktivacijske funkcije. Vsaka enota izračuna novo aktivacijsko vrednost kot funkcijo utežene vsote vhodov in svojo izhodno vrednost posreduje drugim enotam. Modeli se razlikujejo glede na:

- topologijo (število nivojev, povezave med njimi),

- izbiro aktivacijskih in izhodnih funkcij,

-

uporabo učnega pravila.

Najpogosteje uporabljene aktivacijske funkcije so sigmoidne ali linearne, izhodne pa so lahko deterministične ali stohastične. Spremembe uteži skozi čas omogočajo učenje in prilagajanje, kar je bistvena značilnost teh modelov.

Vrste učenja

Nadzorovano učenje temelji na primerjavi med dejanskim in želenim izhodom, sistem pa na podlagi napake prilagodi svoje uteži. To je metoda, ki jo je uporabljal že Rosenblatt pri razpoznavanju likov.

Nenadzorovano učenje pa poteka brez vnaprej podanih pravilnih izhodov. Primer takega pristopa je Hebbovo pravilo, ki določa, da se povezava med dvema enotama okrepi, če sta hkrati aktivni. Tak način učenja omogoča samoorganizacijo mreže, kar pomeni, da se sistem brez zunanjega nadzora nauči prepoznati strukture v podatkih.

Prednosti konekcionističnih modelov

Konekcionistični pristopi imajo več značilnosti, ki jih ločujejo od simbolnih:

- Vzporedna obdelava informacij, kar omogoča učinkovitejše procesiranje.

- Porazdeljeno znanje, kjer je informacija shranjena v povezavah med enotami, ne v posameznih enotah.

- Robustnost – izguba posameznih enot ne pomeni izgube vsega znanja, sistem postopno degradira.

- Asociativni spomin, kjer se novi vzorci sprožijo na podlagi podobnosti z že naučenimi.

- Emergenca – kompleksno vedenje izhaja iz enostavnih pravil delovanja brez centralnega nadzora.

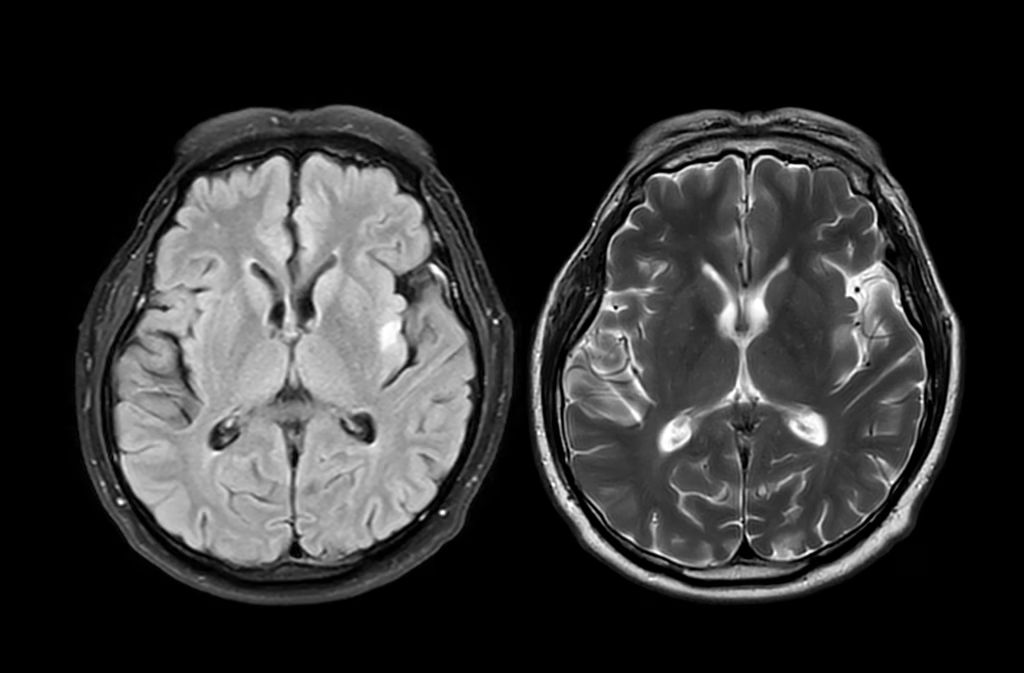

Ti modeli omogočajo tudi simulacijo kognitivnih okvar, kar pomeni, da lahko raziskovalci preučujejo, kako spremembe v strukturi mreže vplivajo na vedenje – analogno poškodbam v možganih.

Omejitve in kritike

Kljub številnim prednostim imajo konekcionistični modeli tudi omejitve. Med pogostejše pripombe sodijo:

- Slaba razložljivost notranjih stanj mrež.

- Biološka nepopolnost – večina modelov ne vključuje kompleksnosti resničnih nevronov, sinaps ali nevrotransmiterjev.

- Velika količina podatkov potrebna za učenje.

- Algoritem povratnega širjenja napake nima neposredne potrditve v bioloških mehanizmih učenja.

Položaj konekcionizma v znanosti o umu

V 80. in 90. letih je prišlo do razprave med zagovorniki konekcionizma in simbolnega računalništva. Slednji trdijo, da je um strukturiran kot jezik, v katerem se simboli kombinirajo po formalnih pravilih. Konekcionisti pa poudarjajo, da sistematičnost in kompozicionalnost ne zahtevata vnaprejšnje razlage simbolov, saj lahko emergentno vznikneta iz dinamike mreže.

Kasnejše raziskave so pokazale, da ni nujno nasprotje med simbolnimi in konekcionističnimi pristopi. Modeli, kot sta ICS (Smolensky) ali CLARION (Sun), združujejo prednosti obeh paradigem in omogočajo bolj celostno razumevanje kognicije.

Konekcionizem ni le tehnična alternativa simbolni umetni inteligenci. Je konceptualni preobrat v razumevanju uma kot dinamičnega, prilagodljivega in distribuiranega sistema. Z združevanjem nevroznanosti, psihologije in računalništva ponuja močno orodje za raziskovanje in modeliranje človekovega mišljenja.

Njegova prihodnost pa leži v integraciji z drugimi pristopi in v prizadevanju za razumevanje kompleksnosti uma skozi mreže, ki se učijo, prilagajajo in samostojno razvijajo znanje – podobno kot mi sami.

Junior novinar